No siempre, pero en

la mayoría de las situaciones en investigación, sí se realizas el estudio en

una muestra. Sólo cuando queremos efectuar un censo debemos incluir todos los

casos (personas, animales, plantas, objetos) del universo o la población. Por ejemplo,

los estudios motivacionales en empresas suelen abarcar a todos sus empleados

para evitar que los excluidos piensen que su opinión no se toma en cuenta. Las

muestras se utilizan por economía de tiempo y recursos. Aquí el interés se

centra en “qué o quiénes”, es decir, en los participantes, objetos, sucesos o

colectividades de estudio (las unidades de muestreo), lo cual depende del

planteamiento y los alcances de la investigación.

Así, en la situación

en que el objetivo sea describir el uso que hacen los niños de la televisión,

lo más factible sería interrogar a un grupo de niños. También serviría

entrevistar a los padres de los niños. Escoger entre los niños o sus padres, o

ambos, dependería no sólo del objetivo de la investigación, sino del diseño de

ésta. En el caso de la investigación que hemos ejemplificado a lo largo del

libro, en la que el propósito básico del estudio es describir la relación entre

los niños y la televisión, se podría determinar que los participantes

seleccionados para el estudio fueran niños que respondieran sobre sus conductas

y percepciones relacionadas con este medio de comunicación.

Criterios para su selección

- Definir los casos (participantes u otros, seres vivos, objetos, fenómenos, procesos, sucesos o comunidades) sobre los cuales se habrán de recolectar los datos.

- Delimitar la población

- Elegir el método de selección de la muestra probabilístico o no probabilístico

- Precisar el tamaño de la muestra requerido

- Aplicar el procedimiento de selección

- Obtener la muestra

Muestreo

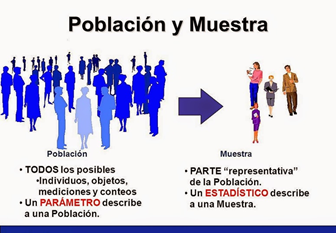

La muestra es, en esencia, un subgrupo de

la población. Digamos que es un subconjunto de elementos que pertenecen a ese

conjunto definido en sus características al que llamamos población. Con

frecuencia leemos y escuchamos hablar de muestra representativa, muestra al

azar, muestra aleatoria, como si con los simples términos se pudiera dar más

seriedad a los resultados. En realidad, pocas veces es posible medir a toda la

población, por lo que obtenemos o seleccionamos una muestra y, desde luego, se

pretende que este subconjunto sea un reflejo fiel del conjunto de la población.

Todas las muestras (en el enfoque

cuantitativo) deben ser representativas; por tanto, el uso de los términos al

azar y aleatorio sólo denota un tipo de procedimiento mecánico relacionado con

la probabilidad y con la selección de elementos o unidades, pero no aclara el

tipo de muestra ni el procedimiento de muestreo. Hablemos entonces de estos

conceptos en los siguientes apartados.

Básicamente, categorizamos las muestras en

dos grandes ramas: las muestras no probabilísticas y las muestras

probabilísticas.

En las muestras probabilísticas, todos los elementos de la población tienen la misma

posibilidad de ser escogidos para la muestra y se obtienen definiendo las

características de la población y el tamaño de la muestra, y por medio de una

selección aleatoria o mecánica de las unidades de muestreo/análisis.

Imagínese el procedimiento para obtener el

número premiado en un sorteo de lotería. Este número se va formando en el

momento del sorteo. En las loterías tradicionales, a partir de las esferas con

un dígito que se extraen (después de revolverlas mecánicamente) hasta formar el

número, de manera que todos los números tienen la misma probabilidad de ser

elegidos.

Ejemplo: Como segundo caso mencionaremos una investigación para saber cuántos niños han sido vacunados contra ciertas enfermedades y cuántos no en un país, y las variables asociadas (nivel socioeconómico, lugar donde viven, educación, etc.) y sus motivaciones. Se conforma una muestra probabilística nacional de —digamos por ahora— 1 600 lactantes, y de los datos obtenidos se toman decisiones para formular estrategias de vacunación, así como mensajes dirigidos a persuadir a la población para que vacunen oportunamente a los niños.

Comentario: este tipo de estudio, en el que se hace una asociación entre

variables y cuyos resultados servirán de base para tomar decisiones políticas

que afectarán a una población, se logra mediante una investigación por

encuestas y, definitivamente, por medio de una MUESTRA PROBABILÍSTICA, diseñada

de tal manera que los datos lleguen a ser generalizados a la población con una

estimación precisa del error que pudiera cometerse al realizar tales

generalizaciones.

En las muestras no probabilísticas, la elección de los elementos no depende de la probabilidad, sino de causas relacionadas con las características de la investigación o los propósitos del investigador (Johnson, 2014, Hernández-Sampieri et al., 2013 y Battaglia, 2008b). Aquí el procedimiento no es mecánico ni se basa en fórmulas de probabilidad, sino que depende del proceso de toma de decisiones de un investigador o de un grupo de investigadores y, desde luego, las muestras seleccionadas obedecen a otros criterios de investigación. Elegir entre una muestra probabilística o una no probabilística depende del planteamiento del estudio, del diseño de investigación y de la contribución que se piensa hacer con ella. Para ilustrar lo anterior mencionaremos tres ejemplos que toman en cuenta dichas consideraciones.

Ejemplo: En un primer ejemplo tenemos una investigación sobre el suicidio en prisiones de Estados Unidos (Suto y Arnaut, 2010). Dado que el suicidio es una causa frecuente de muerte en las cárceles estadounidenses y que la mayoría de los trabajos previos se centraban en cuestiones demográficas y más bien superficiales, los investigadores diseñaron un estudio con el objetivo de explorar los motivos por los cuales los reclusos intentan suicidarse. Para cumplir dicho propósito se seleccionó una muestra no probabilística de prisioneros que accedieran voluntariamente a participar. De esta manera, se realizaron entrevistas exhaustivas a 24 individuos de seis cárceles de Ohio, quienes se expresaron con franqueza sobre sus experiencias.

Comentario: en este caso es adecuada una muestra NO PROBABILÍSTICA, pues se trata de un estudio exploratorio y un enfoque fundamentalmente cualitativo; es decir, no resulta concluyente, sino que su finalidad es documentar ciertas experiencias. Este tipo de estudios pretende generar datos e hipótesis que constituyan la materia prima para investigaciones más precisas. Asimismo, es complicado tener acceso a las prisiones y a los participantes.

Sampieri, R. (1998). Metodología de la

Investigación. Edit, Mac Graw Hill